|

Visual Analytics mit Tableau - eine Potenzialanalyse

Eingereicht von: Christopher Zimmermann

Studiengang: Wirtschaftswissenschaften mit Schwerpunkt Betriebswirtschaftslehre

Referent: Prof. Dr. Michael Amberg

Betreuer: Prof. Dr. Michael Amberg

Bearbeitungszeit: 02.12.2019 - 03.02.2020

Abstract

Big Data und Digitalisierung führen zu digitalen Prozessen und Schnittstellen und lassen so immer mehr Datenvolumen entstehen. Unternehmen haben längst den Nutzen dieser Datenmengen erkannt und versuchen diese bestmöglich zu nutzen. Um daten-getriebene Entscheidungen treffen zu können, muss man die Daten verstehen und benötigt Tools, die dies erleichtern können. Tableau hat sich genau das zum Ziel gesetzt und ist ein Pionier der Datenvisualisierung, mit dem Ziel Visual Analytics für jeden zu ermöglichen. Doch Tableau ist nicht das einzige Unternehmen, das in diesem Markt erfolgreich ist. Um zu evaluieren, welches Potenzial Tableau in diesem Markt besitzt, wird in der folgenden Arbeit die Software anhand einer Expertenbeurteilung analysiert und anhand eines Fragebogens die Ergebnisse festgehalten. Daraufhin wird eine SWOT-Analyse die inneren Stärken und Schwächen und die externen Chancen und Risiken aufdecken. Anschließend wird das Potenzial von Tableau Software eingeschätzt und eingeordnet. Aus der Arbeit geht hervor, dass Tableau Desktop ein Produkt mit guter User Experience ist, welches jedoch bei komplexen Aufgaben unübersichtlich wird. Tableau Software ist daher einer starken Position für weiteres Wachstum. Jedoch gibt es große Konkurrenten, welche durch niedrige Preise und gute Leistung hervorstechen.

Inhaltsverzeichnis

Abbildungsverzeichnis

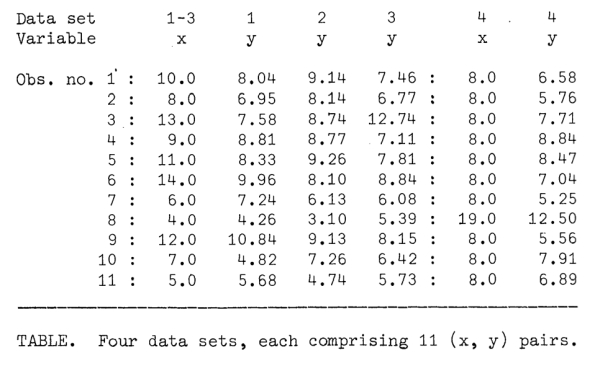

- Abbildung 1: Datensatz von Mathematiker (Anscombe, 1973, S. 19)

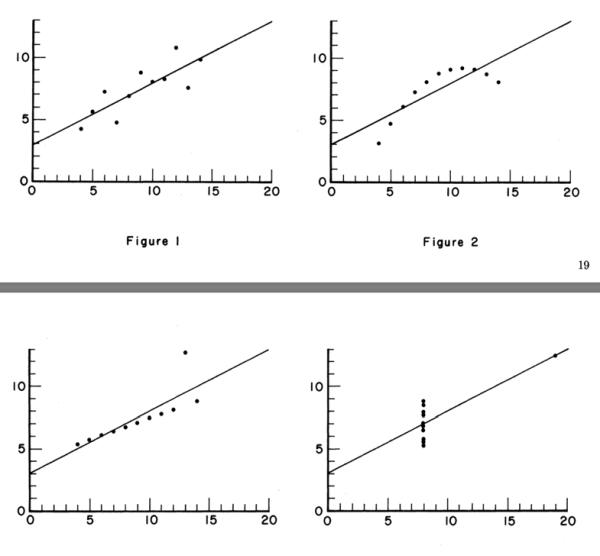

- Abbildung 2: Diagramme zum Datensatz (Anscombe, 1973, S. 19-20)

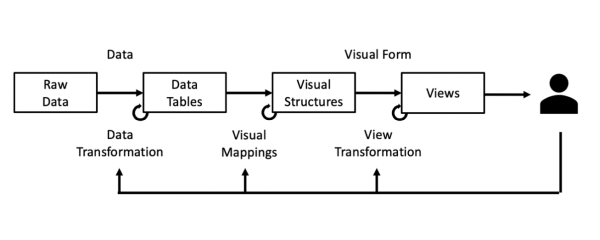

- Abbildung 3: Prozess der Visualisierung (in Anlehnung an: Kard u. a., 1999, S. 17)

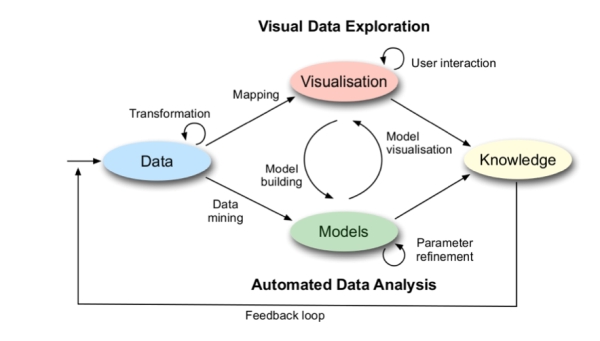

- Abbildung 4: Visual Analytics Prozess (Keim u. a., 2009, S. 3)

- Abbildung 5: Regressionsgerade der Variablen (Urban & Mayerl, 2018, S. 36)

- Abbildung 6: Das Bestimmtheitsmaß R-Quadrat (Urban & Mayerl, 2018, S. 58)

- Abbildung 7: Die SWOT-Matrix (Kamiske, 2015. S. 903)

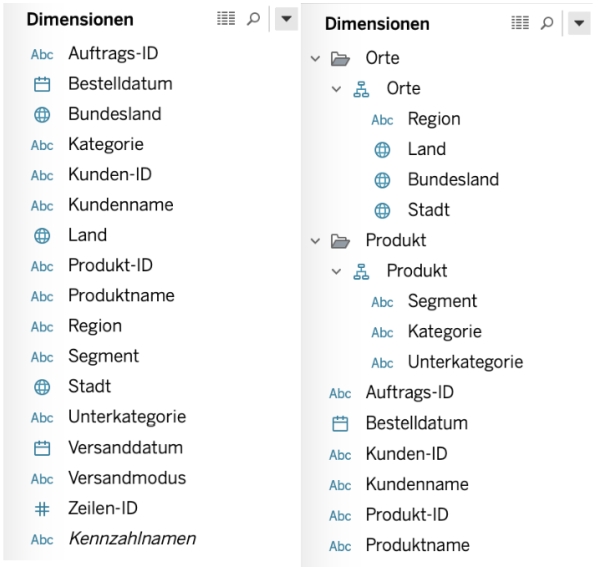

- Abbildung 8: Arbeitsblatt in Tableau Desktop

- Abbildung 9: Hierarchien erstellen

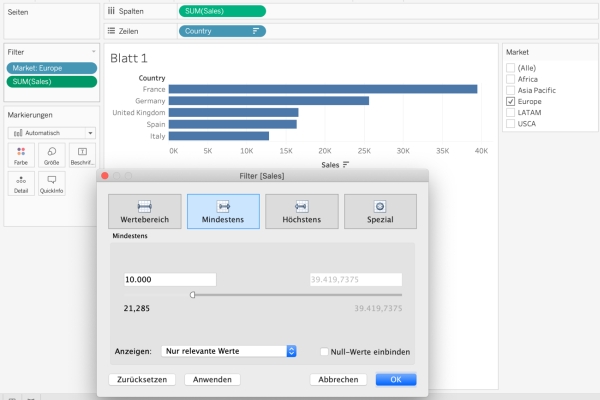

- Abbildung 10: Filterung nach Markt "Europe" und Umsatz größer 10.000

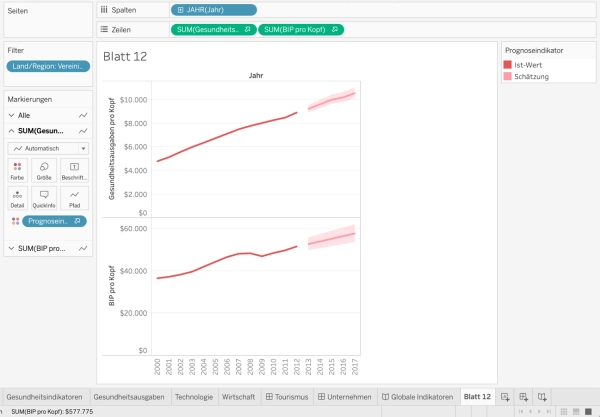

- Abbildung 11: Prognose von Gesundheitsausgaben und BIP pro Kopf der USA

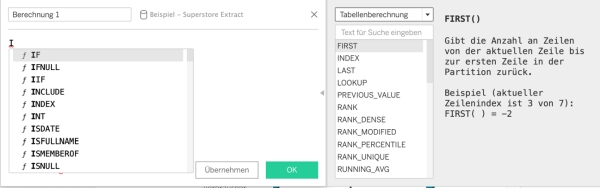

- Abbildung 12: Das Menu der Berechnungen

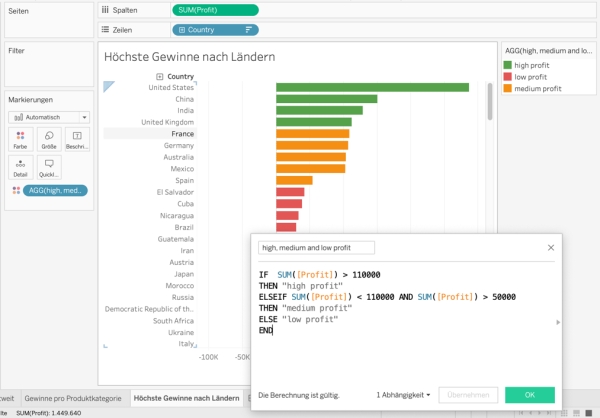

- Abbildung 13: Wenn-Dann-Berechnung

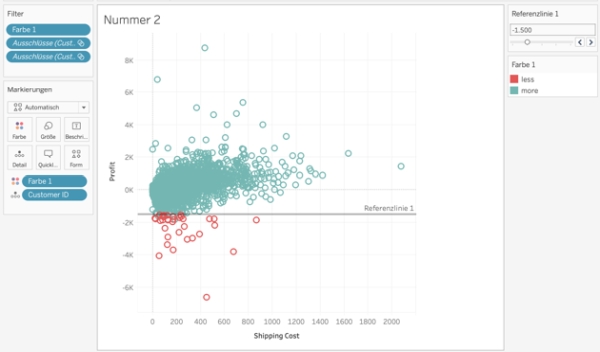

- Abbildung 14: Referenzlinie mit interaktivem Parameter

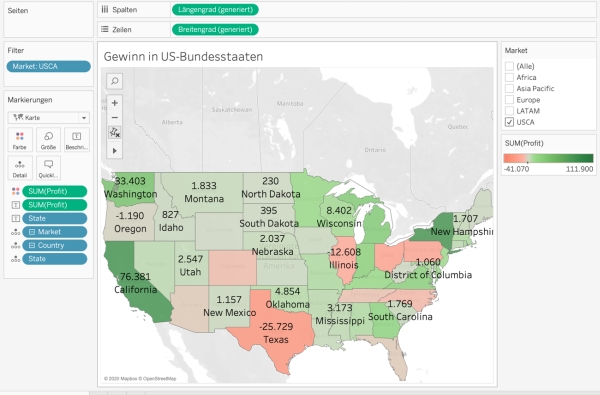

- Abbildung 15: Karte von Gewinnen in US-Bundesstaaten

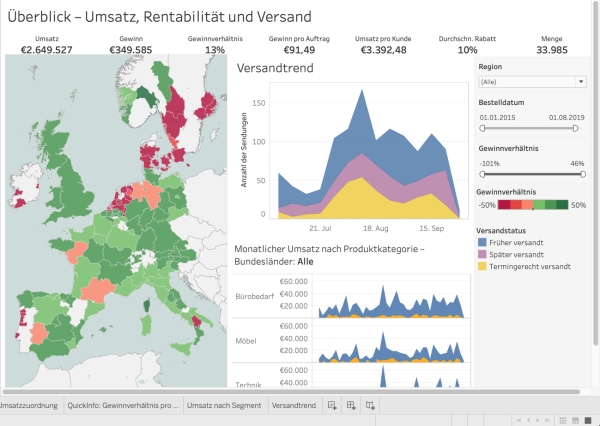

- Abbildung 16: Dashboard mit Umsatz, Rentabilität und Versand

- Abbildung 17: Dashboard mit Filterkriterium "England" und Quickinfo

- Abbildung 18: SWOT Übersicht

- Abbildung 19: Bewertung der Testschritte und Gesamtnote

- Abbildung 20: Gartner Magic Quadrant for Analytics and Business Intelligence (Howson u. a., 2019, S. 6)

Tabellenverzeichnis

1. Einleitung

Große Datenmengen umgeben jeden Menschen im Alltag, auch wenn man sie nicht sehen kann. Ob beim Einkaufen, Autofahren oder beim alltäglichen Surfen im Internet, Daten werden überall gesammelt und gespeichert. Allein die Internetnutzung nimmt stetig zu, 2018 nutzten bereits 3,9 Milliarden Menschen das Internet (Statista, 2019). Die weltweite Datenmenge im Jahr 2018 betrug 33 Zetabyte (Statista, 2018). Doch was passiert mit all diesen Daten? Unternehmen werten die Daten aus und versuchen auf dieser Basis ihr Marktpotenzial voll auszuschöpfen oder ihre Profitabilität zu verbessern. (PricewaterhouseCoopers Aktiengesellschaft Wirtschaftsprüfungsgesellschaft, 2013, S. 19) Das kann einen Mehrwert für Kunden darstellen oder zu ihrem Nachteil sein. Um die richtigen Schlüsse aus den Daten zu ziehen, muss man in der Lage sein, die Daten verstehen und auswerten zu können. Mit den immer größer werdenden Datenmengen wird die Analyse schwieriger. Menschen können diese Menge an Daten kaum überblicken. Doch selbst mit statistischen Methoden und automatisierter Auswertung ist es manchmal schwer, Unterschiede oder Trends in Datensätzen zu finden. So zeigt die folgende Abbildung einen Datensatz mit jeweils elf Beobachtungen für unterschiedliche X- und Y-Werte.

Abbildung 1: Datensatz von Mathematiker (Anscombe, 1973, S. 19)

Durch reine Betrachtung gewinnt man kaum eine Erkenntnis und durch statistische Be-rechnungen kommt man zum Schluss, dass sich die einzelnen Graphen wohl nicht un-terschieden. Der Mittelwert der x-Werte beträgt 9,0, der Mittelwert der y-Werte beträgt 7,5. Daher haben auch alle x -und y-Paare die gleiche Regressionslinie.

Visualisiert man jedoch die Graphen, kann man eindeutige Unterschiede und Trends festmachen. Daher ist es oft hilfreich, eine visuelle Aufbereitung von Daten zu betrachten. So kann man beispielsweise Auf- und Abwärtstrends wesentlich schneller mit bloßem Auge erkennen.

Abbildung 2: Diagramme zum Datensatz (Anscombe, 1973, S. 19-20)

Dies erkannte bereits 1973 Francis John Anscombe, ein englischer Statistiker, zu einer Zeit, in der es Big Data und Visual Analytics noch nicht gab. Mit neuen Methoden der Datenverarbeitung und Analyse ist es nun möglich, riesige Datensätze in kürzester Zeit zu visualisieren und interpretieren.

Daraus hat sich ein neuer Markt gebildet, in dem viele Anbieter Software herstellen, mit welcher schnelle Analysen und neuer Erkenntnisgewinn aus den unerforschten Datenmengen möglich wird.

Ziel dieser Arbeit ist es, das Potenzial eines dieser Anbieter, Tableau Software, zu analysieren. Hierzu werden zunächst theoretische Grundlagen definiert und teilweise voneinander abgegrenzt, da vieles Synonym verwendet wird. Daraufhin wird Tableau Desktop anhand eines Leitfadens getestet und bewertet. Aus diesem Test sollen sich Stärken und Schwächen herausbilden, welche im Rahmen einer SWOT-Analyse eingeordnet werden. Durch die zusätzliche Betrachtung von externen Chancen und Risiken soll sich ein umfassendes Bild von der künftigen Entwicklung des Marktes ergeben. Auf dieser Grundlage wird im Anschluss das Potenzial hinsichtlich der ökonomischen und technologischen Entwicklung analysiert und eingeordnet

2. Vorstellung Tableau Software

Tableau Software ist ein Self-Service Analytics Unternehmen mit Hauptsitz in Seattle und wurde 2003 von Studenten und dem Professor für Computer Science Patrick Hanrahan der Stanford University gegründet (Wikipedia, 2019) (Standford University, 2020). Patrick Hanrahan ist zudem bekannt dafür, Mitarbeiter der ersten Stunde bei Pixar zu sein und hat unter anderem am Animationsfilm "Toy Story" mitgearbeitet. (Tableau Software, 2020d)

Mit Chief Executive Officer Adam Selipsky und mehr als 4000 Mitarbeitern (Stand 31.12.2018) (Tableau Software, 2019a) erreichte Tableau in den ersten beiden Quartalen 2019 zusammen einen Umsatz von rund 545 Millionen Euro, was einen Anstieg gegenüber dem Vorjahr von circa 14,4 Prozent bedeutet (Tableau Software, 2019, S. 5). Das Unternehmen verfügt über einen Kundenstamm von mehr als 86000 Kunden und wurde im Mai 2019 von Salesforce für rund 14 Milliarden Euro übernommen (Handelsblatt, 2019). Der Antrieb für die Übernahme war, Kunden von SalesForce noch mehr Möglichkeiten zu geben, ihren Kundennutzen zu steigern. Tableau soll allerdings weiterhin unabhängig von Salesforce operieren. (Bayer, 2019)

Das Ziel von Tableau Software ist es, einer möglichst breiten Masse den Zugang zu Datenanalyse zu erleichtern. Die Firmenkultur setzt darauf, die eigenen Produkte zu nutzen, um Mitarbeiter nah am Geschehen der Firma zu halten und Überzeugung zu präsentieren. Beispielsweise werden die Nutzungsstatistiken des Programms zum Zweck der Weiterentwicklung direkt in Tableau ausgewertet, ebenso wie die Trends der Personaleinstellungen damit visualisiert werden. (Tableau Software, 2020d) Tableau Software bietet mehrere Produkte an, mit denen die Datenaufbereitung und Analyse erleichtert werden soll. Zur Auswahl stehen verschiedene Lizenzen, die entweder online und von Tableau gehostet oder als Desktop-Anwendung lokal beim Kunden gehostet werden. Für Einzelanwender gibt es die Creator-Lizenz, welche die umfangreichsten Funktionen enthält. Für Firmenkunden gibt es weitere günstigere Lizenzen, wie beispielsweise die Viewer-Lizenz, mit welcher man lediglich die Visualisierung Anderer ansehen kann. (Tableau Software, 2020c) Darüber hinaus gibt es noch weitere Programme zur Datenbereinigung sowie eine mobile Version, um auch auf Tablets und Smartphones die Visualisierungen zu sehen. (Tableau Software, 2020a)

3. Theoretische Grundlagen zu Visual Analytics

3.1 Big Data

Big Data wird heutzutage in den Medien oftmals als Überbegriff für verschiedene Situa-tionen und Szenarien genutzt, hinter denen sich große Datenmengen verstecken. Diese Datenmengen können beispielsweise bei der Nutzung von Social Media Plattformen entstehen. Durch die vielfältige Nutzung des Begriffs, ist die Bedeutung verschwommen und nicht mehr klar abzugrenzen. Eine in der Literatur häufig genutzte Definition geht auf Doug Laney zurück, der Big Data mit drei Eigenschaften beschreibt, welche häufig mit "3V's" abgekürzt werden. Das erste der "3V's", wie sie häufig abgekürzt werden, steht für Volume, also die vorhandene oder zu verarbeitende Datenmenge. Velocity steht für die Geschwindigkeit, mit der neue Daten entstehen oder generiert werden. Variety steht für das Datenformat, in denen die Daten gespeichert sind und zur Verfügung stehen. (Laney, 2001)

Andrea De Mauro, Marco Greco und Michele Grimaldi haben die Nutzung des Begriffs Big Data in der Wissenschaft untersucht und festgestellt, dass man die Nutzung in drei Gruppen unterteilen kann. Die erste Gruppe nutzt die "3V's" als Definition von Big Data. Die zweite Gruppe nähert sich dem Begriff, in dem sie von der benötigten Rechen-leistung der genutzten Systeme ausgehen, die nötig sind, um mit der gegebenen Datenmenge klarzukommen. Die letzte Gruppe definiert den Begriff Big Data so, dass der Mehrwert für die Gesellschaft und Wirtschaft im Mittelpunkt steht. (De Mauro, Greco, & Grimaldi, 2014)

Aus diesen drei Blickwinkeln haben die Wissenschaftler versucht eine allgemein gültige Definition zu bilden: "Big Data represents the Information assets characterized by such a High Volume, Velocity and Variety to require specific Technology and Analytical Methods for its transformation into Value" .(De Mauro u. a., 2014, S. 104)

3.2 Data Mining

Data Mining ist ein interdisziplinäres Forschungsgebiet, das unter anderem aus der Statistik, maschinellem Lernen, Mustererkennung und künstlicher Intelligenz besteht. Data Mining ist dabei nur ein Schritt im Prozess der Knowledge Discovery in Databases, welcher die Wissensextraktion aus Rohdaten durch mehrere Schritte beschreibt, in dem hilfreiche und verständliche Muster erkannt werden. (Fayyad, Piatetsky-Shaprio, & Smyth, 1996a)

Das Ziel von Data Mining ist es, Wissen aus Daten zu erkennen. Mit Wissen sind an dieser Stelle allgemeingültige Muster und Zusammenhänge gemeint. (Thomas A. Runkler, 2015)

Es existieren unterschiedliche Definitionen über Data Mining:

"Data mining is the application of specific algorithms for extracting patterns from data" (Fayyad, Piatetsky-Shaprio, & Smyth, 1996, S. 82)

"Data mining is the process of discovering interesting patterns and knowledge from large amounts of data" (Han, Kamber, & Pie, 2012, S. 8)

"Data mining is the process of discovering meaningful correlations, patterns and trends by sifting through large amounts of data stored in repositories. Data mining employs pattern recognition technologies, as well as statistical and mathematical techniques" (Gartner, 2020b)

All diese Definition haben gemein, dass es um das Entdecken und Extrahieren von Mustern aus Daten geht. Oft geht es nicht nur um die Analyse von Datensätzen, sondern um die Analyse von großen Datensätzen in Datenbanken. Data Mining stellt also eine Möglichkeit dar, Wissen aus Big Data zu gewinnen. (Olson & Wu, 2017)

Dabei kann man in deskriptive und präskriptive Verfahren unterscheiden. Deskriptives Data Mining beschränkt sich darauf, die bereits vorhandene Datenstruktur zu untersuchen, um Muster und Verbindungen aufzudecken. (Olson, 2017)

Prädiktive Verfahren hingegen erweitern das Blickfeld durch künstliche Intelligenz, um durch die Anwendung von Modellen Vorhersagen zu treffen. (Olson & Wu, 2017)

3.3 Visualisierung

Visualisierung von Informationen wird in der Literatur oft wie folgt definiert: "The use of computer-supported, interactive, visual representations of data to amplify cognition" (Kard, Mackinlay, & Schneiderman, 1999). Diese Definition beinhaltet, dass menschliche Interaktion mit einem Computer, um Daten visuell zu präsentieren, den Erkenntnisgewinn fördert. Dabei wird noch in zwei Bereiche unterschieden. Ist der Ursprung der Daten wissenschaftlich und physikalisch, so spricht man von wissenschaftlicher Visualisierung. Sind die Daten abstrakter, also nicht physikalischer Natur, so spricht man von Informationsvisualisierung. (Kard u. a., 1999) In der nachfolgenden Arbeit wird vermehrt Fokus auf Informationsvisualisierung gelegt.

Visualisierung bringt die Möglichkeit mit sich, große Datenmengen schnell zu überbli-cken, denn Menschen nehmen mehr durch das Sehen wahr, also durch alle anderen Sinne zusammen. (Ware, 2013, S. 2). Nach dem Mantra der Visualisierung: "Overview first, zoom and filter, then details on demand" (Shneiderman, 1996, S. 337) gibt es dafür eine klare Abfolge der Arbeitsschritte, um vom Blick auf das große Bild durch Filtern und Vergrößern schließlich auf Details zu schließen.

Allerdings bringt die menschliche Komponente auch Schwierigkeiten mit sich. Zum ei-nen gibt es die Change Blindness, also die Herausforderung der Menschen, Verände-rungen in Visualisierungen wahrzunehmen. Ändern sich visuelle Darstellungen nur geringfügig, so kann der Mensch dies ausschließlich feststellen, wenn er sich kurz zuvor auf den jeweiligen Punkt konzentriert hat. (Ware, 2013, S. 380-381) Zum anderen gibt es den sogenannten Lie Factor, der Anwender zu falschen Interpretationen verleitet. Der Lie Factor beschreibt die Differenz zwischen Daten und der Visualisierung der Daten. (Tufte, 2007, S. 57)

Im folgenden Modell werden die einzelnen Schritte von den Rohdaten bis zur finalen Visualisierung der Daten im Visualisierungsprozesses dargestellt. Der Prozess besteht dabei aus mehreren iterativen Schritten.

Abbildung 3: Prozess der Visualisierung (in Anlehnung an: Kard u. a., 1999, S. 17)

Data Transformation und Data Tables

Die vorliegenden Daten sind zunächst in beliebigem Format gespeichert, beispielsweise in Text oder Tabellenform. In diesem Format sind häufig Fehler enthalten, wie beispielsweise ein fehlender oder falscher Wert. Um diese Fehler korrigieren zu können, müssen die Daten in eine Tabelle überführt werden. Diese Tabelle bringt die Daten in eine relationale Form, wobei die Relationen mit Metadaten verknüpft werden, welche sie beschreiben. Das kann in Form von Zeilen- und Spaltenüberschriften sein. Dieser Schritt ist entweder mit Erkenntnisgewinn - oder Verlust verbunden. Im Falle, dass man nicht alle Daten in die Tabelle überführen kann, geht Information und damit Erkenntnis verloren. Ein Erkenntnisgewinn kann vorkommen, wenn man in den strukturierten Tabellen nachvollziehen kann, wo sich Fehler befinden und diese korrigieren kann. Darüber hinaus ist dieser Schritt sinnvoll, da sind die meisten Computerprogramme darauf ausgelegt, mit strukturierten Tabellen zu arbeiten. Die Tabellen können dann, je nach Art der Daten, in verschiedenen Visualisierungen dargestellt werden

Visual Mappings und Visual Structures

Beim Visual Mapping werden die Datentabellen in visuelle Strukturen überführt. Visuelle Strukturen sind Strukturen, welche eine räumliche und grafische Komponente kombinieren. Für das "Mapping" gibt es verschiedene Wege, wobei darauf geachtet werden muss, dass alle Daten repräsentiert werden, aber keine zusätzlichen Daten durch das Mapping hinzukommen, welche nicht im Datensatz enthalten sind. Dies kann bei-spielsweise durch ungewollte visuelle Effekte entstehen. In diesem Fall liegt eine ausdruckvolle visuelle Struktur vor. Eine weitere wichtige Eigenschaft ist die Effektivität. Diese wird erreicht, wenn man die Visualisierung schnell und einfach interpretieren kann, was allerdings von der menschlichen Wahrnehmung abhängig ist.

View Transformation

Um zu einer aussagefähigen Visualisierung zu gelangen, kann man im letzten Schritt den Blickwinkel wechseln. Dazu existieren drei verbreitete Konzepte der "View Trans-formation". Dazu gehören "Location Probes, Viewpoint Controls und Distortion", welche nachfolgend beschrieben werden.

Location Probes

Location Probes können genutzt werden, um additionale Information zu zeigen. Dies kann in Form eines Popp-up-Fensters geschehen, in dem der Nutzer über eine gewisse Stelle in der Visualisierung fährt. Ähnlich funktioniert eine Art Linse, welche den entsprechend markierten Bereich vergrößert, um mehr Details erkennen zu können. Location Probes können aber auch in Form von Durchschnittslinien Verwendung finden.

Viewpoint Controls

Viewpoint Controls machen es dem Nutzer möglich, eine neue Perspektive einzuneh-men, in dem man in einen Bereich zoomen und einen Bildschirmausschnitt verschieben kann. Allerdings findet bei beiden Aktionen ein Verlust des Kontexts statt, welchen sich der Nutzer entweder merken muss oder mehrmals raus- und reinzoomen muss, um den Kontext bei der Betrachtung zu beachten.

Distortion

Distortion beschreibt die Verzerrung eines Teils der Visualisierung, um mehr Details darin einzufügen. Diese Aktion beschreibt also die Verknüpfung von Kontext- und Detailansicht in einer Visualisierung. Dadurch kann der Nutzer den Teilbereich mit Details näher analysieren, wobei das Kontextwissen erhalten bleibt. (Kard u. a., 1999, S. 17-33)

3.4 Visual Analytics

Analytics wird verwendet, um statistische und mathematische Datenanalyse zu be-schreiben, welche die wahrscheinlichsten Szenarien vorhersagt. (Gartner, 2020a)

Visual Analytics ist ein interdisziplinärer Ansatz, welcher Visualisierung, menschliche Interaktion und Datenanalyse verbindet, um aus Daten Wissen zu generieren. Dabei werden Visualisierung und Analytics kombiniert und um weitere Schritte ergänzt. (Keim, Mansmann, Stoffel, & Ziegler, 2009, S 1-2)

Die erste Definition des Begriffs stammt von James J. Cook Thomas und Kristin A. Cook: "Visual Analytics is the science of analytical reasoning facilitated by iterative visual interfaces" (Thomas & Cook, 2013, S. 4)

Eine präzisere Definition wurde später von Daniel Keim et al. geliefert: "Visual analytics combines automated analysis techniques with interactive visualizations for an effective understanding, reasoning and decision making on the basis of very large and complex data sets" (Keim u. a., 2008, S. 157)

Der Kern beider Definitionen ist also eine interaktive, menschliche Komponente und eine automatisierte, analytische Komponente. Die automatisierte Komponente kommt vor allem durch Methoden der Statistik, Mathematik und Informatik zum Einsatz. Ein besonderes Augenmerk liegt hierbei auf Machine Learning und Data Mining. Der Mensch konzentriert sich also auf die Fähigkeiten der Interaktion, Präsentation, Beurteilung und Entscheidungsfindung sowie Visualisierung. Durch diese Vielfalt an Methoden und die Kombination von Menschen und Maschine kann großes Potenzial für verschiedenste Einsatzbereiche entstehen, um effektiv Abweichungen, Trends und Aus-reißer zu lokalisieren und analysieren.

3.5 Visual Analytics Prozess

Der Visual Analytics Prozess setzt sich aus automatischen und visuellen Methoden zusammen. Zunächst ist es notwendig, dass entsprechend geordnete Datenquellen zur Verfügung stehen. Diese müssen, falls noch nicht geschehen, in sinnvolle Einheiten umgewandelt und richtig gegliedert werden. Sind die Daten im richtigen Format vorhanden, kann die eigentliche Analyse beginnen. Im Hinblick auf wachsende Datenmengen und Zeitreihen, die auf herkömmlichen Bildschirmen nicht mehr abgebildet werden können, wurde das Mantra der Visualisierung "Analyze first, Zoom, filter and analyze further, Details on demand" um den Punkt "[...] show the important [...]" ergänzt. Dies soll die Dringlichkeit von ersten automatischen Analysen aufzeigen, welche den Anwender darauf hinweisen sollen, an welchen Stellen er seine Suche nach Information starten soll, im Falle, dass der vorhandene Datensatz zu groß für eine gesamtheitliche Betrachtung ist. Dies geschieht mit Hilfe von Machine Learning und Data Mining. Im nächsten Schritt ergänzen sich menschliche Interaktion und automatische Analysemethoden, so dass durch mehrmalige Umgestaltung der Visualisierung Ekenntnisse aus den Daten gewonnen werden können. Eine Umgestaltung kann Beispielsweise eine neue Ansicht, Umskalierung oder Zoomen sein. Dabei ist dies kein optionaler, sondern wichtiger Schritt im Prozess. Dies beruht auf der Tatsache, dass sich der menschliche Anwender, im Gegensatz zum Computer, leicht vom ersten Eindruck täuschen lässt. Um dies zu vermeiden, müssen die Daten aus verschiedenen Perspektiven betrachtet werden. Diese Schritte erinnern an die Datenvisualisierung, welche bereits beschrieben wurde. Der Nutzer kann gleichzeitig auch die Parameter für die automatischen Analysen, wie Beispielsweise Data Mining, bestimmen. Durch das Zusammenspiel von einem berechnenden, emotionslosen System und dem kreativen, entscheidenden Nutzer können so Mehrwerte generiert werden, um effizienter und effektiver zu den gewünschten Ergebnissen zu kommen. (Keim u. a., 2009)

3.6 Datenqualität

Die Qualität von Auswertungen, Analysen und visuellen Darstellungen hängt immer von der Qualität der verwendeten Daten ab. Selbst der beste Algorithmus kann mit unvollständigen, inkonsistenten Datensätzen kein gutes Ergebnis erzielen. Im schlimmsten Fall entstehen Ergebnisse, welche das Problem, den Datensatz oder die Methode noch komplexer erscheinen lassen. Um einen schnellen, effektiven und effizienten Datenverarbeitungsprozess zu gewährleisten, ist es essentiell wichtig, dass eine hohe Datenqualität vorliegt. Dadurch kann sich nicht nur die Bearbeitungszeit minimieren, sondern das Ergebnis präzise bestimmt werden. Hohe Datenqualität ist dabei immer kontextabhängig, solange aber mit den Daten das gewünschte Ergebnis erzielt werden kann, ist die Qualität hoch. Grundsätzlich lassen sich jedoch die folgenden Punkte als Mängel in Datensätzen bestimmen.

Abbildung 4: Visual Analytics Prozess (Keim u. a., 2009, S. 3)

Fehlende Werte

Fehlende Werte können auf verschiedene Ursachen zurückzuführen sein. In Unternehmen kann es vorkommen, dass vor der Analyse der Datensätze nicht bekannt war, dass der benötigte Wert wichtig ist. In diesem Sonderfall fehlen allerdings ganze Spalten oder Zeilen mit den entsprechenden Werten. Häufiger kommt es vor, dass die Aufzeichnung und Speicherung der Werte fehlerhaft ist, was zu einem oder mehreren fehlenden Einträgen in der Spalte oder Zeile führt. Es gibt verschiedene Möglichkeiten, wie man mit fehlenden Werten umgehen kann. Am einfachsten ist es, wenn man diese ignoriert und die Analyse trotzdem ausführt, was zu falschen Ergebnissen führen kann. Des Weiteren kann man die komplette Zeile oder Spalte aus der Analyse entfernen, dadurch geht allerdings der Informationsgehalt, auch wenn dieser vorher nicht vollständig vorhanden war, verloren. Eine weitere Möglichkeit besteht darin, für die fehlenden Werte, je nach Menge und Größe des Datensatzes, Schätzungen vorzunehmen. Dies kann allerdings ebenso zu falschen Werten und damit zu Verzerrungen führen.

Redundante Werte

Redundante Werte sind Werte, welche mehrfach vorhanden sind und keine neue Information zu den bereits vorhandenen beinhalten. Im Extremfall handelt es sich hierbei um exakte Kopien. Diese Daten sind dann irrelevant und sollten vor der Analyse entfernt werden, da sie den Prozess verlangsamen können.

Inkonsistente Daten

Inkonsistente Daten liegen vor, wenn ein Wert nicht zu einem anderen logischen Wert passt. Ein Beispiel hierfür wäre, wenn in einem Datensatz mit ausschließlich Erwachsenen befragten die Körpergröße in Zentimetern gemessen wird. Kommt dabei ein Wert von beispielsweise 10 vor, ist dies ein inkonsistenter Wert. Dies kann in Analyseprozessen, wie Machine Learning Analysen, zu verringerter Qualität und Fehlern führen. Auch hier ist es eine Möglichkeit, die falschen Werte neu zu schätzen oder komplett zu entfernen. (Moreira, de Carvalho, & Horváth, 2018)

3.7 Grundlagen der Statistik

3.7.1 Regression und Bestimmtheitsmaß

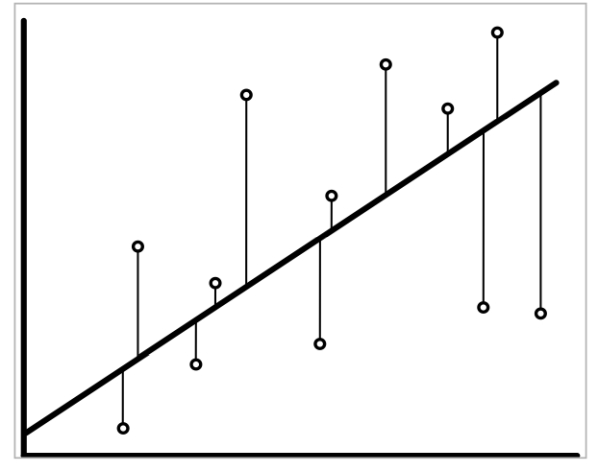

Bei einer Regressionsanalyse werden die minimalen quadratischen Abstände von Variablen, den sogenannten Residuen, zu einer gemeinsamen Regressionsgeraden errechnet, um den Zusammenhang von zwei oder mehr Variablen herauszufinden.

Abbildung 5: Regressionsgerade der Variablen (Urban & Mayerl, 2018, S. 36)

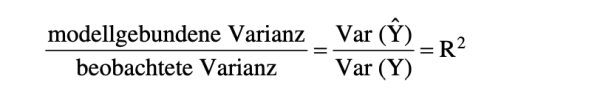

Um zu bestimmen, ob die Regressionsgerade einen hohen Wahrheitsgehalt hat, kann man das Bestimmtheitsmaß heranziehen. Das Bestimmtheitsmaß, auch als R2 bezeichnet, kann Werte von 0 bis 1 annehmen. Ein Wert von 0 bedeutet, dass es keinen Zusammenhang gibt und die Werte willkürlich um die Gerade verstreut sind. Ein Wert von 1 bedeutet, dass alle Werte auf der Regressionsgeraden liegen. Das Bestimmtheitsmaß gibt also an, wie viele Prozent der beobachteten Streuung der Residuen durch das Modell erklärt werden können (s. Abbildung 6). (Urban & Mayerl, 2018)

Abbildung 6: Das Bestimmtheitsmaß R-Quadrat (Urban & Mayerl, 2018, S. 58)

3.7.2 P-Wert

Der P-Wert ist ein Mittel zur Testentscheidung statistischer Tests. Bei einseitigen Tests, also Tests die darauf abzielen, eine Nullhypothese zu bestätigen oder zu verwerfen, gibt der P-Wert die sogenannte Überschreitungswahrscheinlichkeit an. Die Nullhypothese ist dabei immer das Gegenteil von dem, was der Test eigentlich beweisen soll. Der P-Wert ist also die Wahrscheinlichkeit dafür, dass ein Fehler erster Art vorliegt, also die aufgestellte Nullhypothese richtig ist, aber fälschlicherweise abgelehnt wird.

Um nun eine maximale Toleranzgrenze festzulegen, bestimmt man das Signifikanzniveau. Dieses wird üblicherweise auf 10%, 5% oder 1% festgelegt. Ist der errechnete P-Wert kleiner als dieser vorher festgelegte Wert, so wird die Nullhypothese abgelehnt. Damit ist die eigentliche Hypothese nicht bestätigt, aber die kann zumindest nicht abgelehnt werden. (Reinhold, Eckey, & Türck, 2019)

3.7.3 Prognoseverfahren

Prognosen liegt zu Grunde, von bereits bekannten Daten und deren Mustern auf zukünftige, unbekannte Daten und Muster zu schließen. Um Prognosen durchzuführen, gibt es verschiedene Modelle der Zeitreihenanalyse. Beim Modell der exponentiellen Glättung werden alle bisherigen Beobachtungen mit einem Glättungsfaktor zwischen 0 und 1 berücksichtigt. Ist der Glättungsfaktor 0, wird der Wert nicht mit einbezogen, ist der Wert 1, wird der Wert ohne Glättung übernommen. Zur Bestimmung des Glättungsfaktors wird entweder die erste beobachtete Variable oder ein Durschnitt der beobachteten Variablen herangezogen. Jede prognostizierte Variable wird dann in die nächste Berechnung der nächsten Variable einbezogen. Somit wird die Prognose immer weiter aktualisiert. Der Vorteil dieses Verfahrens ist, dass es sich auch für besonders kurze Zeitreihen unter 30 Beobachtungen eignet. Umso länger jedoch die Zeitreihe ist, umso genauer ist auch die Prognose. (Bachleitner & Weichbold, 2016)

4. Forschungsmethode

4.1 Expertenbeurteilung

Die Expertenbeurteilung ist eine von einer einzelnen Person durchgeführte Beurteilung einer Software, um die User-Experience und Funktionen anhand vordefinierter Aufgaben festzustellen. Das Wort Experte bezieht sich hierbei nicht ausschließlich auf die Fachkunde der beurteilenden Person in Bezug auf die Software, sondern auch schon auf die Erfahrung im Umgang mit verschiedener Software und Benutzeroberflächen. Die Expertenbeurteilung ist eine Methode, die aus der Softwareentwicklung stammt.

Um die Beurteilung durchzuführen, muss ein Testplan erstellt werden. Zunächst ist es hierbei wichtig, dass sich der Experte mit dem Testprodukt und Konkurrenzprodukten auseinandersetzt, um ein erstes Gespür für die Software zu bekommen. Dazu kann es hilfreich sein, die Hersteller-Websites, Internetforen und Produktvideos zu begutachten. Es soll dabei gelingen, die wichtigsten Elemente und Funktionen der Software herauszuarbeiten und die relevanten Aufgaben in Form einer Liste zu extrahieren. Mit dieser Liste soll getestet werden, ob und wie gut wichtige User-Experience Attribute bei der Ausführung der Kernfunktionalitäten gewahrt werden.

Während des Tests wird in der Liste die jeweilige Note (1 = gut, bis 6 = ugenügend) vergeben. Dazu müssen jeweils Kategorien erarbeitet werden, die für die einzelnen Testschritte bewertet werden können. Diese Kategorien ergeben sich aus funktionalen Anforderungen und UX-Anforderungen, die typisch für Visual Analytics Software ist.

Anhand der von Tableau veröffentlichten Datensätze und Beispiele wird der Test der Software durchgeführt und daraufhin die Ergebnisse in der erstellten Liste notiert(Tableau Software, 2020b). Daraus soll sich ein umfassendes Ergebnis herausbilden, welches die vorgegebenen Aufgaben abdeckt und mögliche Erfolge und Probleme hervorhebt. (Wilson, 2014, S34-48)

Zum Test wird Tableau Desktop herangezogen, da es sich im Funktionsumfang nur unwesentlich von Tableau Online und Tableau Server unterscheidet. (Senturus, 2020)

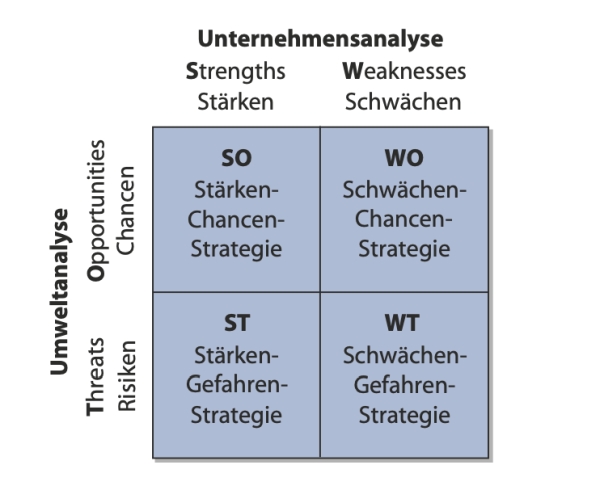

4.2 SWOT-Analyse

Die SWOT-Analyse soll die Stärken, Schwächen, Chancen und Risiken eines Unternehmens im Marktumfeld herausstellen. Es wird die interne und externe Analyse unterschieden. Die externe Analyse wird für die Einschätzung der Chancen und Risiken der Umwelt genutzt, da diese unvermeidbar auf das Unternehmen einwirkt. Zunächst wird dabei die makroökonomische Umwelt betrachtet, speziell die technologische und ökonomische Umwelt. Daraufhin wird die mikroökonomische Unternehmensumwelt betrachtet, also die für Tableau Software relevante Branchenumwelt. Hier soll vor allem auf potenzielle Konkurrenten eingegangen werden.

Die interne Analyse beschäftigt sich mit dem Analysieren der Stärken und Schwächen, welche für das untersuchte Unternehmen relevant sind. Diese können beispielsweise aus den finanziellen Mitteln und Kompetenzen des Unternehmens abgeleitet werden. Zunächst wird hierzu das Geschäftssystem, in dem Tableau Software tätig ist, bestimmt. Dieses wird über die Aktivitäten definiert, welche in der relevanten Branche ausgeübt werden, um Kunden eine Leistung zu erbringen. Im zweiten Schritt werden die kritischen Erfolgsfaktoren bestimmt, die für das Unternehmen von Bedeutung sind. Diese können beispielsweise Innovationsfähigkeit oder Marktabdeckung sein. Anhand der so gesammelten Informationen können Stärken und Schwächen eingeschätzt werden. Es bildet sich die Position des Unternehmens im Branchenvergleich mit Stärken und Schwächen heraus.

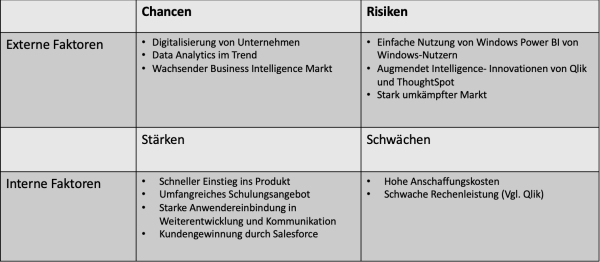

Die Ergebnisse werden in der SWOT-Matrix graphisch dargestellt, woraus sich im Anschluss eine geeignete Strategie und somit auch das Potenzial von Tableau Software ergibt. (Hungenberg & Wulf, 2015, S. 152-170)

Abbildung 7: Die SWOT-Matrix (Kamiske, 2015. S. 903)

5. Analyse von Tableau Software

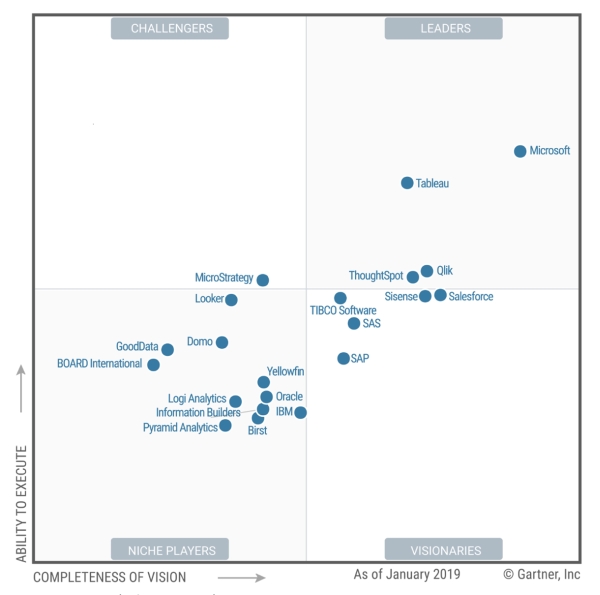

5.1 Erstellung der Checkliste

Bei der Erstellung der Checkliste muss zunächst herausgearbeitet werden, welche wichtigen Funktionen die Software erfüllen sollte. Hierzu wurde der Gartner Magic Quadrant for Analytics and Business Intelligence herangezogen, aus welchem hervorgeht, welche Kriterien von Gartner festgelegt wurden, die kritisch für den Erfolg der Software sind. (Howson, Richardson, Sallam, & Kronz, 2019)

Die von Gartner festgelegten Funktionen sollten in allen im Magic Quadrant enthaltenen Produkten verfügbar sein. Dennoch ergeben sich Unterschiede in den Kernfunktionen, wenn man die größten Konkurrenten von Tableau betrachtet. Dazu gehört Microsoft Power Bi und Qlik. (Microsoft, 2020a) (QlikTech Gmbh, 2020a)

Die Funktionen kann man in zwei Bereiche einteilen:

Tabelle 1: Kritische Software-Funktionen nach Gartner (Howson u. a., 2019)

| Vorbereitung: |

| - Datenkonnektivität zu strukturierten und unstrukturierten Daten |

| - einfache Drag&Drop Datenvorbereitung und Verknüpfung von mehreren Datensätzen |

| - Management von Metadaten (Bsp.: Hierarchien, Dimensionen, Kennzahlen) |

| Visualisierung und Analytics: |

| - Ermöglichung von schnell nutzbarer, menügeführter Data Analytics für Nicht-Data Scientists |

| - Vielzahl von Data Exploration Möglichkeiten (Heatmaps, Landkarten und Streudiagramme) |

| - Verfügbarkeit von Programmschnittstellen zur Erweiterung der Funktionalitäten |

| - automatische Analyse von Korrelationen und Vorhersagen |

| - einfache Bedienbarkeit, attraktives Erscheinungsbild |

Anhand dieser Funktionen wurde der Testleitfaden erstellt. Dieser soll die meisten Teilbereiche abdecken. (s. Anhang)

Bewertungskriterien

Die Grundlage der Bewertungskriterien (s. Anhang) bilden die Vergleiche zwischen den einzelnen Tools. Dabei wurden die Hersteller-Websites nach den enthaltenen Features untersucht und Vor- und Nachteile mit einbezogen. Daraus hat sich abgeleitet, dass die Menüführung besonders wichtig ist. Hinzu kommt, dass Visual Analytics ein sehr interdisziplinäres Fachgebiet ist und daher schnell tiefergehendes Wissen benötigt wird, um Aufgaben auszuführen, weshalb "vorausgesetztes Wissen" ein weiteres Kriterium ist. Nachdem Fachwissen alleine nicht reicht, um die Software richtig zu nutzen, ist es auch wichtig zu wissen, was zu tun ist, um an das Ergebnis zu kommen. Daher ist die "Klarheit der Arbeitsschritte" ein Kriterium. Dazu kommt, dass nicht alle Programmteile bei allen Anbietern im gleichen Funktionsumfang ausgebaut sind und dieser deshalb wichtig ist, um die Software zu beurteilen. (Microsoft, 2020a) (QlikTech Gmbh, 2020a)

5.2 Analyse von Tableau Software anhand des Testleitfadens

Der Leitfaden ist mehreren typischen Workflows mit Tableau nachempfunden. Dabei sollen die wichtigsten Funktionen abgebildet und getestet werden. Tableau stellt eigene Datensätze für die wichtigsten Features zu Verfügung, welche im nachfolgenden Teil genutzt werden. Da es sich um viele unterschiedliche Workflows handelt, können diese nicht mit einem einzigen Datensatz bearbeitet werden.

Datensätze importieren, aufbereiten und kombinieren

Bei der Auswahl der Datensätze ist zu beachten, dass es sich nicht um unsortierte Rohdaten handelt, sondern bereits erste Schritte unternommen wurden, um eine aussagekräftige Analyse zu gewährleisten. Im Test wurde mit Excel-Dateien gearbeitet. Idealerweise stehen in der ersten Zeile eindeutige Spaltennamen, welche den Inhalt der Spalte klar von den anderen Spalten abgrenzen. Zudem ist darauf zu achten, dass keine Überschriften oder sonstige Notizen über der ersten Zeile der eigentlichen Daten stehen, da Tableau dies nicht erkennt und die Spaltennamen nicht übernimmt. Ebenfalls werden Spalten, die nicht zum eigentlichen Datensatz gehören, nicht erkannt.

Für dieses Problem hat Tableau Software eine Lösung bereitgestellt. Mit dem sogenannten "Data Interpreter" kann die Software die überflüssigen Bestandteile erkennen und lässt diese beim Import der Datei weg. Somit kann man ohne manuelle Bearbeitung des Datensatzes Zeit sparen und Dateien schneller importieren.

Der Data Interpreter funktioniert ebenfalls, wenn mehrere Tabellen in der ursprünglichen Datei enthalten sind. Tableau zeigt dann mehrere Arbeitsblätter mit den verschiedenen Inhalten an. Mit Data Joins und Unions kann man mehrere Datensätze gleicher oder unterschiedlicher Quellen zusammenführen. Die Voraussetzung dafür ist, dass mindestens ein Spalteninhalt übereinstimmt. Tableau erkennt diese und kann die entsprechenden Daten richtig zuordnen. Zudem kann man die übereinstimmenden Spalten auch manuell hinzufügen. Darüber hinaus kann der Anwender entscheiden, welche Daten kombiniert werde. Beispielsweise gibt es die Option, nur die gemeinsam enthaltenen Spalten oder alle zusätzlichen Daten zum bereits vorhandenen Datensatz zu übernehmen.

Ein weiteres Feature ist das Pivotieren von Spalten in Zeilen, welches helfen kann, um mit den Daten besser arbeiten zu können. Beispielsweise können Jahreszahlen mit dazugehörigen Werten jeweils in einer eigenen Spalte angegeben sein. Ist dies der Fall, erkennt Tableau für jede Jahreszahl eine eigene Spalte mit Überschrift, wodurch es sehr aufwändig ist, mehrere Jahreszahlen in eine Visualisierung zu ziehen. Durch das Pivotieren macht Tableau aus mehreren Spalten eine Spalte, in der die Jahreszahlen übereinander angegeben sind. Das Aufteilen von Spalten kann beispielsweise bei Datensätzen von Vorteil sein, wenn man Namen in Vor- und Nachnamen aufteilen möchte. Da es vorkommen kann, dass die in den Spalten enthaltenen Daten nicht immer einheitlich sind, kann man entweder automatische Aufteilungen nutzen, in dem die Software selbst nach einer sinnvollen Aufteilung sucht, oder manuell entsprechende Parameter festlegen.

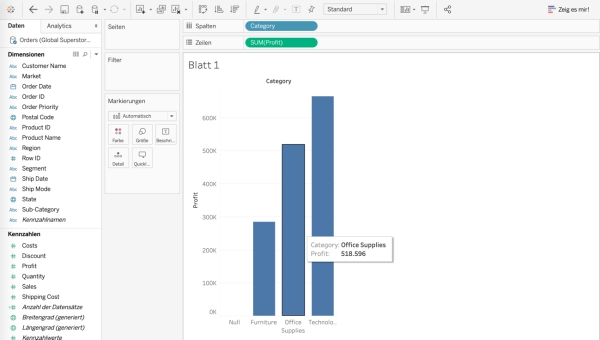

Erstellen von Visualisierungen

Ist die Vorbereitung der Datenquellen abgeschlossen, kann man mit der Visualisierung und Exploration der Daten beginnen. Der Nutzer findet sich in der Arbeitsblatt-Ansicht wieder, in der auf der linken Seite die Spaltenüberschriften der Datenquelle als Dimensionen und Kennzahlen angegeben werden. Dimensionen nehmen meist diskrete Werte an, Kennzahlen meist fortlaufende Werte. Diese Typisierung ist allerdings nicht festgeschrieben. Der Nutzer kann individuell bestimmen, welches Feld als Dimension oder Kennzahl bestimmt wird. Tableau trifft zunächst eine automatische Zuordnung. Über und neben der Arbeitsfläche befinden sich die sogenannten Container und Karten. In den Container "Spalten" und "Zeilen" können die Dimensionen und Kennzahlen der Datenquelle per Drag & Drop abgelegt werden. Tableau entwirft daraus direkt eine erste Visualisierung. Man kann mit wenigen Klicks schon aussagekräftige Diagramme erstellen in dem man unterschiedliche Dimensionen und Kennzahlen kombiniert.

Um das vorgegebene Diagramm anzupassen, gibt es den Bereich "Formatierungen". Hier kann man Schriftgrößen, Farben und Rahmen anpassen, um das Diagramm den eigenen Bedürfnissen anzupassen.

Fährt man mit dem Cursor über die Darstellung, so erscheint die Quickinfo mit weiteren Daten, beispielsweise genauen Zahlen oder nicht im Diagramm enthaltene Daten. Abhängig davon, welche Daten zu Verfügung stehen, stellt Tableau hier automatisch zugehörige Informationen bereit. Um das Arbeitsblatt interaktiv zu gestalten, lässt sich die Quickinfo vollständig individuell gestalten und mit Links und Graphiken befüllen, welche sich entsprechend der Position des Cursors anpassen. Zusätzlich kann die Quickinfo auch noch manuell gestaltet werden. Durch das Hinzufügen von Visualisierungen und Berechnungen lassen sich mehr Inhalte in eine Visualisierung zusammenfassen. Auf die Quickinfo wird im Kapitel "Dashboard" genauer eingegangen.

Abbildung 8: Arbeitsblatt in Tableau Desktop

Gruppierungen und Metadaten

Das Gruppieren von Dimensionen, die dem gleichen Kontext angehören, erleichtert das Suchen und Finden von benötigten Feldern, da sich die Menge an Feldern in der Spalte "Dimensionen" verringert. Es gibt verschiedene Wege, wie man Gruppen erstellen kann. Zum einen kann man durch einfaches Rechtsklicken Ordner erstellen und beliebig befüllen. Zum anderen lassen sich Gruppen auch durch Zusammenfassen von Überschriften im Diagramm selbst erstellen, welche dann als eine neue, zusammengefasste Spalte wiedergegeben werden. Je nach Diagrammtyp, gibt es noch weitere Möglichkeiten der Gruppierung. Diese werden jedoch vorerst nicht näher betrachtet.

Das Erstellen von Gruppen ist auch dann von Vorteil, wenn viele Metadaten im Datensatz enthalten sind. Metadaten sind Daten, welche bereits vorhandene Daten ergänzen oder weitere Informationen über diese liefern. Innerhalb dieser Gruppierung kann es darüber hinaus sinnvoll sein, wenn man Hierarchien hinzufügt, wodurch man deutlich übersichtlichere Arbeitsplätze gestalten kann, was für die spätere Arbeit hilfreich ist. Mit Hilfe des so genannten Drilldowns muss man nur noch ein Feld der Hierarchie per Drag & Drop in den Container ziehen und kann im Anschluss entscheiden, wie detailliert die Darstellung sein soll. In Abbildung 9 ist dies zu erkennen. Hier wurden die Felder Kategorie und Unterkategorie zu einer hierarchischen Gruppe zusammengefasst und in einen Ordner verschoben. Genau so wurden auch die Felder "Land", "Bundesland" und "Stadt" zusammengefasst. Darüber hinaus kann man auch den Ordner "Bestellungen" erstellen und alle zugehörigen Felder einsortieren. Die Spalte "Dimensionen" ist nun deutlich übersichtlicher und der Nutzer kann schneller die passenden Felder finden.

Abbildung 9: Hierarchien erstellen

Filtern

Filter können hilfreich sein, um die Ansicht auf bestimmte Daten zu beschränken oder mehr Details zu sehen. Filter können auf verschiedene Art und Weise angelegt werden und funktionieren auch sehr unterschiedlich. Zunächst kann man nach Dimensionen und Kennzahlen filtern. Beispielsweise kann man einen bestimmten Markt herausfiltern und näher betrachten. Daraufhin kann man Filtern, in welchen Ländern dieses Markts ein Umsatz über einer gewissen Grenze liegt. Hierzu wird das entsprechende Feld "Market" und "Sales" per Drag & Drop in den Container "Filter" gezogen und es öffnet sich ein vom Kontext abhängiges Fenster, in welchem man die Einstellungen vornehmen kann. Diese Filterung bleibt auch erhalten, wenn man von der Länder-Ebene auf die Städte- oder Markt-Ebene wechselt.

Des Weiteren kann man auch mit Platzhaltern arbeiten, also nach Wörtern oder Buchstaben filtern, mit denen ein Spaltenname beginnt, endet oder enthält oder nicht enthält.

Hat man bereits eine fertige Visualisierung erstellt, möchte aber eine Zeile oder Spalte entfernen, kann man dies auch direkt aus der Ansicht oder der dazugehörigen Legende tun und muss nicht extra in die Filtereinstellungen wechseln.

Mit Bedingungen kann man zudem Felder auf eine bestimmte Eigenschaft Filtern. Man kann beispielsweise das gleiche Ergebnis wie in Abbildung 10 erreichen, indem man an Stelle von "Sales" das Feld "Country" filtert, in dem man es auf die Bedingung "Sales" über 10.000 filtert. Diese Bedingung gilt dann nur solange, wie das Feld genutzt wird, also in den Containern ist.

Abbildung 10: Filterung nach Markt "Europe" und Umsatz größer 10.000

Mit Hilfe von Kontextfiltern ist es möglich, eine übergeordnete Filterebene zu erstellen. Alle später hinzugefügten Filter basieren folglich auf dieser Filterebene. Diese Funktion ist besonders nützlich, wenn man sich auf einen bestimmten Bereich im Datensatz konzentrieren möchte, ohne wiederholt Filteranpassungen vornehmen zu müssen. In diesem Zusammenhang ist auch das Ausblenden von Filtereinstellungen hilfreich. Die Einstellungen erscheinen standartmäßig am rechten Bildschirmrand. Setzt man einen Kontextfilter, macht es Sinn, diese Einstellungen auszublenden, da man diesen Filter für gewöhnlich nicht oft ändert. Dadurch vergrößert sich auch der Bereich der Visualisierung, vorausgesetzt, man hat nichts anderes an der Seite eingeblendet.

Es besteht außerdem die Möglichkeit, Filter auf ausgewählte Arbeitsblätter zu übertragen oder Filter auf die komplette Datenquelle anzuwenden. Diese Funktion ist besonders nützlich, wenn man sich auf einem Dashboard befindet. Hier werden dann alle angezeigten Visualisierungen mit dem gleichen Filter angezeigt. Auf Dashboards wird im Verlauf der Arbeit noch genauer eingegangen.

Trendlinien und Prognosen

Trendlinien sind ein nützliches Mittel, um in einem Diagramm einen übersichtlichen Zusammenhang von abhängigen Variablen darzustellen. Um eine Trendlinien einzufügen, muss man in den Analytics-Bereich wechseln. Hier kann man das Feld Trendlinie in das Diagramm bewegen und sich entscheiden, welche Form die Linie annehmen soll. Da Trendlinien, je nach Datensatz, sehr ungenau sein können, sollte man prüfen, wie nah die Linie an der Wahrheit liegt. Tableau bietet hier sehr nützliche Features an. Fährt man mit dem Cursor über die Trendlinie, so wird das Bestimmtheitsmaß und der p-Wert angezeigt.

Neben Trendlinien gibt es auch Referenzlinien, welche dazu dienen weitere Informationen im Diagramm wiederzugeben. Dies kann an einem markanten Punkt sein oder nur der Übersicht dienen. Man kann einem Diagramm mehrere Referenzlinien hinzufügen, um Mittelwerte, Summen oder Extremwerte zu zeigen.

Trend- und Referenzlinien basieren auf den bereits vorhandenen Daten, welche in der Vergangenheit gesammelt wurden. Zwar lässt sich von Trendlinien die künftige Entwicklung abschätzen, allerdings kann dies sehr ungenau sein, was man beispielsweise anhand des p-Werts und dem Bestimmtheitsmaß erkennen kann. Um genauere Prognosen zu bekommen, kann man die zukünftigen Entwicklungen von Tableau auf Basis statistischer Modelle berechnen lassen. Tableau nutzt zur Berechnung die Methode der exponentiellen Glättung. Der Nutzer kann hierbei einstellen, wie viele Jahre vorhergesagt werden sollen und auf welchem Konfidenzniveau. Einzelne Parameter des Prognoseverfahrens kann man nicht einstellen und somit muss man auf die Berechnungen Tableaus vertrauen.

Abbildung 11: Prognose von Gesundheitsausgaben und BIP pro Kopf der USA

Berechnungen und Parameter

Mit Berechnungen lassen sich in Tableau Informationen berechnen, welche noch nicht im Datensatz enthalten sind. Die Logik hinter den Berechnungen ist sehr unterschiedlich, da es verschiedene Möglichkeiten gibt. Man kann verschiedene Bereiche unterteilen, beispielsweise in einfache Prozent- und Tabellenkalkulation, Logikberechnung und Wenn-Dann-Berechnungen. Ein berechnetes Feld kann über das Menü erstellt, wobei eine Autofill-Funktion Operatoren und Felder zum Berechnen vorschlägt.

Abbildung 12: Das Menu der Berechnungen

Besonders visuell wahrnehmbar sind Wenn-Dann-Berechnungen, wenn man diese farbig in Diagrammen oder auf Karten darstellt. Dazu muss die Berechnung eingeben werden und mit OK bestätigt werden, falls diese keine Syntax-Fehler enthält. Danach wird das berechnete Feld auf den Container "Farbe" gezogen, um das Balkendiagramm abhängig vom erzielten Gewinn einzufärben.

Abbildung 13: Wenn-Dann-Berechnung

Mit Hilfe von Parametern kann man interaktive Graphiken erstellen. Im Gegensatz zu Filtern, welche die Daten auf ausgewählte Inhalte beschränken, dienen Parameter dazu, dynamische Werte in Berechnungen, Filtern oder Referenzlinien anzunehmen. In Abbildung 14 kann man nach den Bestellungen filtern, die über oder unter der Referenzlinie liegen. Somit kann man beispielsweise die Bestellungen, die mehr als 1000 Euro Verlust eingebracht haben herausfiltern und genauer untersuchen. Dazu muss man den Bereich mit den roten Bestellungen markieren und kann die dazugehörigen Zahlen in einer extra Tabelle öffnen, da Tableau die Werte zu jedem Punkt der Abbildung 14 bereitstellt.

Abbildung 14: Referenzlinie mit interaktivem Parameter

Karten

Tableau verfügt über eine Vielzahl an Optionen, um Daten auf Karten darzustellen. Das Programm erkennt beispielsweise Felder wie "Land", "Stadt" oder "Bundesland" und kann die Daten dann entsprechend dem richtigen Ort zuweisen. Erkennt Tableau nicht automatisch, dass es sich um geographische Daten handelt, so kann man dies via weniger Klicks richtigstellen. Darüber hinaus kann man Orte auch über die manuelle Eingabe von Längen- und Breitengraden vornehmen. Eine erste einfache Visualisierung mit Karten wird durch einen Doppelklick auf ein geographisches Feld erstellt. Dabei wird beispielsweise jedes enthaltende Land auf einer Weltkarte dargestellt. Durch das hinzufügen des Gewinns, in dem man das Feld "Gewinn" auf die Markierung "Farbe" zieht, werden die Länder entsprechend dem ausgefallenen Gewinn eingefärbt. Möchte man nur die Bundesländer eines bestimmten Landes untersuchen, kann man mittels der Drilldown-Hierarchie von der Markt-Ebene bis zur Bundesland-Ebene gehen. Um nähere Informationen zur Höhe des Gewinns und Namen des Bundeslandes zu bekommen, kann man das Feld "Profit" und "State" auch auf Text ziehen und erhält die genaue Zahl des Gewinns und den Namen. Je nach Zoom erscheinen mehr oder weniger Namen und Zahlen. (s. Abbildung 15).

Neben der flächendeckenden Einfärbung der Länder lassen sich Karten individuell gestalten. So kann man verschiedene Kennzahlen in Form von dynamischen Kreisen oder Heatmaps darstellen und mit Parametern interaktiv gestalten.

Abbildung 15: Karte von Gewinnen in US-Bundesstaaten

Dashboards und Storys

Dashboards ermöglichen es, mehrere Visualisierungen und Storys gleichzeitig zu betrachten. Sie können helfen, einen Überblick über die Unternehmenslage insgesamt oder über einem speziellen Teilbereich zu liefern, in dem man sie durch Filter, Legenden und Texte interaktiv gestalten kann. Selbst Websites können eingebunden werden und behalten ihren Funktionsumfang. So kann man Filter auf die verschiedenen Arbeitsblätter im Dashboard übertragen, wodurch nicht nur die ausgewählte Ansicht gefiltert wird, sondern alle eingestellten.

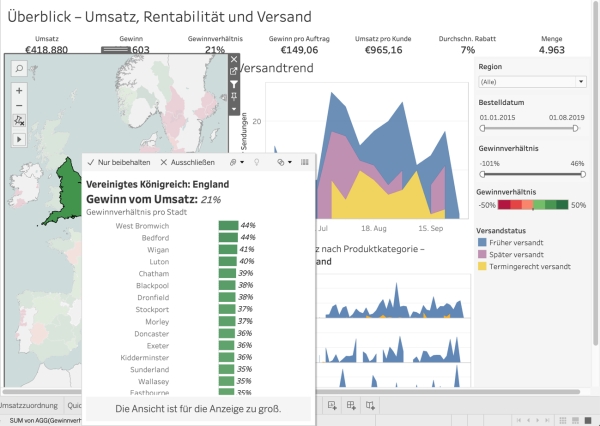

Um ein Dashboard zu erstellen, müssen die gewünschten Ansichten bereits vorher auf Arbeitsblättern erstellt werden. Dann kann man die Ansichten auf das Dashboard ziehen und anordnen. Tableau unterstützt den Nutzer, in dem es die Größen und Formen automatisch anpasst, auch wenn der Nutzer diese im Nachgang nochmal verändern möchte. In Abbildung 16 ist ein Dashboard abgebildet, auf dem kein Filter ausgewählt wurde. Auf Abbildung 17 wurde dann England als Filterkriterium ausgewählt und die zwei anderen Ansichten haben sich entsprechend angepasst. Außerdem kann man in der Quickinfo weitere Informationen erhalten, beispielsweise welche Städte das größte Gewinnverhältnis haben. Hierzu wurde in einem separaten Arbeitsblatt eine entsprechende Visualisierung erstellt. Diese wird in der Quickinfo in Abbildung 17 integriert.

Dashboards und Storys haben ihre eigene Logik, wie Änderungen auf die zu Grunde liegenden Visualisierungen wirken. Fügt man einen Inhalt einer Story hinzu, so aktualisiert sich dieser mit einer Änderung der Visualisierung. Ändert man etwas in der Story, so stoppt die automatische Aktualisierung und die Story bleibt auf diesem Stand. Die Änderung wirkt sich auch nicht auf die zu Grunde liegende Visualisierung aus. Dies gilt allerdings nur für die Änderungen, die in der Story getätigt wurden. Alle anderen Änderungen in der Visualisierung haben eine Aktualisierung in der Story zur Folge, bis zu dem Zeitpunkt, bei dem die entsprechende Änderung in der Story durchgeführt wird.

Änderungen in Dashboards hingegen wirken sich auch auf die zu Grunde liegende Visualisierung aus und auf Storys, die die gleiche Visualisierung enthalten. Das bedeutet auch, dass Dashboards immer aktualisiert werden, wenn man etwas in einer Arbeitsmappe einer enthaltenen Visualisierung ändert.

Abbildung 16: Dashboard mit Umsatz, Rentabilität und Versand

Abbildung 17: Dashboard mit Filterkriterium "England" und Quickinfo

6. SWOT-Analyse

6.1 Chancen und Risiken

Chancen

Die Digitalisierung und damit einhergehende Prozessdigitalisierung rufen immer größere Datenmengen in Unternehmen hervor. Jedes Jahr wächst die Datenmenge um etwa 27 Prozent im Vergleich zum Vorjahr und wird bis 2025 175 Zetabyte erreichen. (Infoamtionsdienst des Instituts für deutsche Wirtschaft, 2019) Unternehmen wollen diese Daten nicht ungenutzt lassen, da in ihnen viel Wissen und Potenzial steckt. Auch das Bundeswirtschaftsministerium unterstützt Unternehmen mit dem Projekt "Demand", um eine Infrastruktur für modernes Datenmanagement zu errichten. (Fraunhofer-Institut für Software- und Systemtechnik ISST, 2020)

In der IT-Beratung und Kundenfirmen wird für die nächsten Jahre weiterhin mit Umsatzwachstumsraten von durchschnittlich mehr als zehn Prozent gerechnet, was unter anderem daran liegt, dass Unternehmen immer mehr Unterstützung bei Themen wie agile Entwicklung, Backend-IT und Data Analytics benötigen. (Lünendonk, 2019, S. 51)

Diese Entwicklungen bilden die Grundlage für einen weiterwachsenden Business Intelligence Markt, was auch durch die Fakten gestützt wird. Tableau agiert in einem stark wachsenden Markt, der sich ausgehend von 2016 bis 2021 mit einer jährlichen Wachstumsrate von circa 15% nahezu verdoppeln und auf etwa 6,5 Milliarden Euro Marktvolumen anwachsen wird. (Marketsandmarkets, 2020)

Wie eine Umfrage des Business Application Research Centers 2019 mit über 2865 Unternehmen ergab, liegt Self Service Business Intelligence, wie Tableau, auch 2020 weiter im Trend. Die Umfrage hatte zum Thema, welche Business Intelligence Trends bei den befragten Unternehmen den höchsten Stellenwert einnehmen. (Business Application Research Center, 2019, S.15)

Der Erfolg wird auch durch die Nutzung untermauert, da immer mehr Analysen von nicht speziell ausgebildeten Anwendern durchgeführt werden. So setzen Unternehmen vermehrt darauf, Mitarbeiter mit den Self-Service Analytics Tools vertraut zu machen und damit Entscheidungsgrundlagen für das Team, die Abteilung oder ganze Bereiche generieren zu können. (Gartner, 2018)

Auch Tableau konnte von diesem Trend profitieren, wie das Umsatzwachstum der letzten Jahre beweist. Seit 2010 hat sich der Umsatz um den Faktor 33 erhöht. Im Jahr 2018 konnte man den Umsatz um circa 12,1% von 790 Millionen Euro auf 885 Milliarden Euro steigern, berücksichtigt man die Änderung der Buchhaltungsvorschriften. ("Form 10-K Tabelau Software, Inc.", 2014)

Für das Jahr 2019, ausgehend von einer Verdopplung des Umsatzes der ersten zwei Quartale, steigert Tableau den Umsatz ein weiteres Mal um circa 4,8% von 1,04 Milliarden Euro auf 1,09 Milliarden Euro. (Tableau Software, 2019b)(Tableau Software, 2019a)

Geht man also von einem weiter anhaltenden Trend aus, so sollte sich dies auch positiv für Tableaus Geschäftstätigkeit auswirken.

Risiken

Die größten Risiken für Tableau sind die starken Konkurrenten, die auch vom wachsenden Markt profitieren wollen. Hier ist Microsoft mit Power BI zu nennen sowie Qlik und Thoughtspot.(Howson u. a., 2019)

Microsoft bietet für Unternehmen, deren Systeme auf Windows basieren, einen leichten Einstieg in die Welt der Business Analytics. Power BI kann als Basisversion kostenlos im Rahmen von "Office 365 E5"genutzt werden und ist somit leicht integrierbar. (Microsoft, 2020b)

Darüber hinaus ist Windows das mit Abstand am weitesten verbreitete Betriebssystem überhaupt und stellt somit hinsichtlich der Gewohnheiten der Nutzer eine Gefahr für Tableau dar. Power BI ist für die meisten Windows-Nutzer mit einem bereits vertrauten User Interface ausgestattet, was die Nutzung deutlich erleichtert und die Einarbeitung und Umstellung zu einer neuen Software minimiert. (Statista, 2020)

Power BI ist deutlich günstiger als Tableau, wenn es nicht im Office-365 Paket ohnehin enthalten ist. Dafür bietet Power BI bislang allerdings auch einen kleineren Funktionsumfang. Es bleibt allerdings abzuwarten, wie lange dieser Vorsprung im Funktionsumfang hält. Sollte Microsoft ernsthafte Ambitionen in diesem Markt haben, wäre es wohl eines der wichtigsten Ziele, hier aufzuholen. Glaubt man dem Gartner Magic Quadrant, so hat Microsoft Tableau im Jahr 2019 bereits als Leader für Business Intelligence abgelöst. (Howson u. a., 2019)

Qlik ist ein weiteres Datenvisualisierungstool, welches sich einer großen Beliebtheit erfreut. Im Unterschied zu Tableau gelingt es Qlik bei großen Datenmengen die Performance aufrecht zu erhalten und schnelle Aktualisierungen zu bieten. Mit Augmented Intelligence bietet Qlik ein Feature, mit dem man Stichworte eingeben kann, wodurch im Anschluss automatisch passende Diagramme und Analysen erstellt werden.

(Qlik, 2020)

ThoughtSpot geht einen Schritt weiter als Qlik und bietet die Möglichkeit, in Form von natürlicher Sprache Fragen einzugeben, welche danach in Form von Auswertungen und Visualisierungen beantwortet werden. (Thoughtspot, 2020)

Diese Funktionen ermöglichen es selbst Nutzern, die nicht über Basiswissen über Daten und Analyse verfügen, Visualisierungen und Dashboards zu erstellen, die aussagekräftige Informationen enthalten.

Damit erreichen die drei Hauptkonkurrenten die gleiche Zielgruppe wie Tableau und bieten mit guter User Experience und innovativen Produkten Alternativen zu Tableau. Wie dem Gartner Magic Quadrant zu entnehmen ist, gibt es darüber hinaus eine Vielzahl weiterer potenzieller Konkurrenten für Tableau, was bedeutet, dass der Markt künftig deutlich umkämpfter wird und neue Innovationen Gefahren birgen können.

6.2 Stärken und Schwächen

Stärken

Tableaus Stärken liegen in der Konstanz der User Experience und dem leichten Einstieg, wodurch Tableau ein ideales Tool ist, um schnelle Visualisierungen zu erstellen. Darüber hinaus unterstützt es den Nutzer dabei, diese geeignet zu formatieren. Das ermöglicht eine schnelle Informationsaufnahme bei den Betrachtern der Visualisierung. Einfache Visualisierungen benötigen keine mathematischen oder statistischen Grundkenntnisse und sind innerhalb von wenigen Schritten erstellt. Auch bei komplexeren Visualisierungen und Explorationen bleibt die User Experience [UX] konstant gut und die gleichbleibenden Workflows helfen dem Nutzer schnell die richtigen Entscheidungen zu treffen, um an das Ziel seiner Analyse zu erreichen. Die gute UX bildet dabei ein stabiles Fundament, um die Fähigkeiten auszubauen.

Tableau bietet zahlreiche Schulungs- und Weiterbildungsangebote in Form von Präsenz- und Onlinetrainings an. Ein neuer Anwender kann somit bequem vom Arbeitsplatz mit dem Training starten, in dem er aus über 13 Stunden kostenlosen Schulungsvideos wählen kann. Darüber hinaus gibt es eine Vielzahl weiterer Möglichkeiten, mit Experten in Kontakt zu treten. Beispielsweise gibt es neben eLearnings und Webinare sogenannte Learning Paths, die je nach Rolle und Ziel der Nutzung von Tableau verschiedene Möglichkeiten und Schritte kombiniert.

Sollte der Anwender nicht mehr weiterkommen und auf Hilfe angewiesen sein, so kann er sich an die Tableau-Community wenden. Die Community besteht aus vielen Nutzern, welche sich gegenseitig bei Fragen und Problemen unterstützen. Tableau hat es geschafft, die Community zu einem seiner Erfolgsfaktoren zu machen, da dadurch langfristig Personal beim Kundensupport eingespart werden kann. Durch die Präsenz von ausgewählten Tableau-Botschaftern und Zen Mastern, die jeweils Expertenwissen und langjährige Erfahrung besitzen, wird das Wissen verbreitet und festgehalten, sodass sich neue Anwender daran orientieren können.

Nicht nur der Anwender profitiert von einer stark ausgeprägten Community, sondern auch Tableau selbst. Durch den engen Kontakt zu den Kunden und aktuellen Themen, die die Kunden beschäftigen, kann Tableau Kundenwünsche direkt aufnehmen und in die Weiterentwicklung des Produkts einfließen lassen. Dies wirkt sich besonders positiv auf die Einstellung der Anwender aus, da diese das Gefühl bekommen, ernst genommen zu werden.

Durch die Community erleichtert Tableau also nicht nur den Einstieg in das Programm, sondern erhöht damit langfristig Kundenzufriedenheit und Kundenbindung, indem diese nicht wie Kunden, sondern Partner angesehen werden.

Neben den Stärken des Produkts, der Community und der Kundenbindung reinvestiert Tableau außerdem einen großen Anteil am Gewinn in Forschung und Entwicklung. Allein 2018 betrug der Anteil vom Rohgewinn circa 38% und machte eine Summe von rund 344 Millionen Euro aus. (Tableau Software, 2019a)

Diese hohe Summe ist im Markt mit vielen Konkurrenten äußerst wichtig, um durch Innovationen und Weiterentwicklungen bestehender Produkte für Kunden attraktiv zu bleiben.

Neben den selbst erarbeiteten Stärken kann Tableau über eine weitere, von außen zugeführte Stärke zurückgreifen. Denn durch die Übernahme durch Salesforce im Laufe des Jahres 2019 könnten sich neue Kunden für Tableau ergeben. Salesforce ist mit fast 12 Milliarden Euro Umsatz einer der führenden Anbieter im wachsenden Markt der Customer-Relation-Software und Cloud-Technologie. In den vergangen Jahren hat Salesforce einige Übernahmen getätigt, um Kunden mehr Nutzen zu bieten und das Geschäft auszubauen (Kermann, 2018). Das Ziel der Übernahme von Tableau ist den Kunden von Salesforce durch Tableaus Visual Analytics Plattform ein noch tieferes Verständnis für ihre Daten zu ermöglichen und dabei Tableau vorerst weiter selbstständig operieren zu lassen (Bayer, 2019). Für Tableau bedeutet dies viele potenzielle Neukunden, die leicht zu erschließen sind.

Schwächen

Tableau bietet verschiedene Lizenzprogramme an, aus denen eine Firma ihre benötigten Optionen wählen kann. Standardmäßig muss dabei mindestens ein Creator-Account enthalten sein. Die Explorer- und Viewer-Accounts sind dabei frei wählbar. Allerdings hat man mit dem Viewer-Account nur die Möglichkeit, Dashboards anzusehen, welche von Nutzern mit Creator- und Explorer-Account erstellt wurden.

In einer von Tableau finanzierten Studie aus dem Jahr 2017 wird das Ergebnis bestätigt, dass die Anschaffungskosten für Tableau deutlich größer sind als vergleichsweise bei Power BI. In der Studie geht man zunächst von einem Use-Case von 100 aktiven Creator-Lizenzen und 1000 Consumer-Lizenzen aus. Die Preisdifferenz beträgt dabei circa 1,7 Millionen Euro, wobei bei Tableau rund 2,3 Million Euro und bei Power BI nur rund 570.000 Euro fällig werden. Zwar argumentiert Tableau, dass sich der langfristige Preisunterschied zu Gunsten von Tableau entwickelt, jedoch werden hierfür die Zahlen für Personalkosten für Installation und Anwendung geschönt dargestellt, wie einige kritische Artikel berichten. (Kirwin & Brooks, 2017)

Auch für Einzelnutzer ist der Preis ein eher abschreckendes Argument. Einzelnutzer müssen logischerweise die komplette Bandbreite der Produktpalette nutzen und können daher nur den Creator-Account erwerben, welcher circa 63 Euro monatlich kostet. (Tableau Software, 2020c)

Für den Preisunterschied in der Anschaffung bietet Tableau zwar mehr Features, trotzdem ist es für Unternehmen, vor allem mit Windows basierten Systemen eine Überlegung wert, das günstigere Power BI zu nutzen. (Microsoft, 2020c)

Ein weiterer negativer Aspekt ist die langsame Rechenleistung von Tableau. Gerade bei großen Datensätzen muss der Anwender etwas länger warten. Möchte man große Datensätze wie beispielsweise den "Global Superstore" mit über 35000 Zeilen kombinieren oder den Data Interpreter von Tableau nutzen, dauert es einige Sekunden, bis die Daten geladen haben und man den nächsten Schritt machen kann. Dies zieht sich bis in die Datenanalyse, wo man, je nach Datenintensität der Visualisierung, kurz warten muss. Grund dafür ist eine langsamere Cubing-Rechenmethode (Milligan, 2015). Nutzt man Qlik mit deutlich schnellerer In-Memory-Processing Technik, so ist dieses Problem unbekannt. Für den Workflow ist dies positiv, da man nicht in der Nutzung unterbrochen wird. (QlikTech Gmbh, 2020b)

7. Ergebnisse

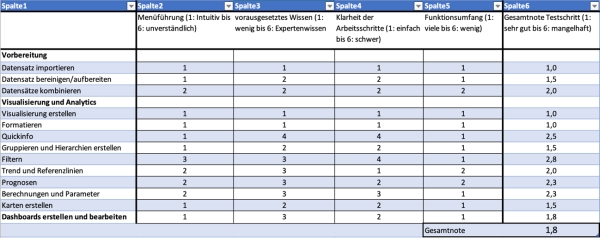

7.1 Expertenbeurteilung

Die Expertenbeurteilung wurde anhand der erstellten Checkliste durchgeführt. Zu jedem Punkt in der Liste wurde ein spezifischer Workflow durchgeführt. Teilweise wurden auch Workflows kombiniert und Aufgaben mehrfach, mit Abweichungen, durchgeführt, falls dies für ein umfangreiches Testergebnis nötig war. Nach jedem ausgeführten Testschritt wurde für die jeweiligen Kategorien eine Teilnote vergeben und anschließend eine Gesamtnote errechnet, welche sich aus der Summe der Teilnoten dividiert durch die Anzahl der Teilnoten ergibt.

Allgemein

Insgesamt ist die Menüführung in Tableau Desktop sehr klar strukturiert und dem Anwender gelingt es meist schnell, das gesuchte Menü zu finden und die entsprechende Funktion auszuwählen. Durch die einfache Anordnung der verschiedenen Menüpunkte am oberen Rand des Bildschirmes, was an Windows-Programme erinnert, fühlt es sich wie eine gewohnte Arbeitsumgebung an. Dennoch gibt es Ausreißer im Programm, die nicht besonders intuitiv gestaltet sind und daher die Nutzung erschweren. Auf diese wird im Folgenden gesondert eingegangen. Diese Menüs werden meist dann gebraucht, wenn man in einem Anwendungsszenario arbeitet, welches intensiveres Fachwissen erfordert. Dadurch erhöht sich Komplexität insgesamt und daher vermindert sich die Klarheit der Arbeitsschritte.

Lediglich der Funktionsumfang sticht durch eine konstant gute Bewertung hervor. Tableau befindet sich allerdings auch im oberen Preissegment und daher sollte ein hoher Funktionsumfang zu erwarten sein. Es ergibt sich daher eine Gesamtnote von 1,7 für Tableau Desktop in Schulnoten ausgedrückt (s. Abbildung 19)

Vorbereitung

Das Importieren eines Datensatzes von einem lokalen Speicherort des Computers ist sehr einfach, da die Menüführung aus gängigen anderen Programmen bekannt ist und kein besonderes Wissen vorausgesetzt wird. Es sind nur wenige Arbeitsschritte von Nöten, um eine Datenquelle anzubinden und somit ist dem Anwender stets klar, was er zu tun hat. Darüber hinaus verfügt Tableau über eine große Bandbreite an akzeptierten Datenformaten. Insgesamt fällt das Urteil also sehr positiv für diesen Teilschritt aus und bekommt daher die Note 1,0.

Das Aufbereiten von Datensätzen in Tableau kann entweder automatisch oder manuell geschehen. Die automatische Aufbereitung sollte allerdings manuell überprüft werden. Möchte man den Datensatz manuell bearbeiten, ist allerdings eine gewisse Einarbeitung notwendig. Für komplexeres Aufbereiten und manuelles Bereinigen wird mehr Wissen vorausgesetzt und ist daher auch etwas schwieriger durchzuführen. Daher wird für den Testschritt "Daten bereinigen/aufbereiten" eine Gesamtnote von 1,5 vergeben. Der Testschritt "Datensätze kombinieren" kommt durch die eine etwas kompliziertere Menüführung und durchweg schwierigere Durchführung im Vergleich zum Importieren auf eine Gesamtnote von 2,0.

Visualisierung und Analytics

Die Erstellung von Visualisierungen ist in Tableau sehr einfach. Schon durch einfaches Ausprobieren der Drag&Drop-Funktionen gelingt es, verschiedene Diagramme und Ansichten zu erstellen, da Tableau die Inhalte selbst erstellt und anpasst. Für den Testschritt "Visualisierung erstellen" wird demnach eine 1,0 vergeben, da die Software sehr intuitiv aufgebaut ist. Möchte man die Visualisierungen allerdings mit mehr Inhalten füllen oder interaktiv gestalten, erhöht sich das Schwierigkeitsniveau stark. Ein Beispiel hierfür ist die Quickinfo. Diese wird standardmäßig von Tableau erstellt und mit Inhalten befüllt. Möchte der Anwender diese selbst befüllen, so gibt es dazu viele verschiedene Möglichkeiten, was grundsätzlich sehr positiv ist. Allerdings führt dies auch zu Komplikationen in der Umsetzung. Zunächst wird großes Wissen vorausgesetzt, um die vielen verschiedenen Berechnungen und Verlinkungen zu beherrschen. Erschwerend kommt hinzu, dass nicht immer klar ist, auf welchem Arbeitsblatt und unter welcher Einstellung Änderungen vorgenommen werden müssen, da die vielen verschiedenen Logiken an unterschiedlichen Stellen ineinandergreifen. Aufgrund dessen kommt die Quickinfo nur auf eine Note von 2,5 im Test.

Das Formatieren der Visualisierung hat eine sehr einfache Menüführung, welche auch an die der Windows-Programme erinnert. Das Erstellen von Hierarchien innerhalb der Dimensionen ist durch die Drag & Drop-Funktionalität ebenso einfach zu handhaben. Es ist bei den typischen Workflows auch jederzeit klar, wo die benötigten Funktionen zu finden sind und wie man diese umsetzt. Etwas mehr Wissen und etwas unklarere Arbeitsschritte gibt es beim Erstellen von Gruppen. Diese kann man, je nach Gruppierungsregeln, sehr komplex gestalten. Für gewöhnlich würde man dies allerdings nicht so komplex gestalten und daher erhält dieser Testschritt insgesamt eine Note von 1,5.

Das Filtern ist eine sehr umfangreiche Funktionalität in Tableau. Die Menüführung für einfache Filter ist sehr gut umgesetzt. Dennoch wird die Bewertung durch eine Vielzahl redundanter Stellen verringert. Hinzu kommt, dass es in Tableau keine Übersicht über bereits erstellte Filter gibt, außer, man geht in das Menü jedes einzelnen Filters. Dies mindert die Übersichtlichkeit erheblich, da sich Filter auf Arbeitsblätter und Dashboard gleichzeitig auswirken können. Ebenso unübersichtlich ist das Anwenden von Filtern, die auf verschiedenen Ebenen greifen. Durch die Vielzahl von Anwendungsszenarien kommt automatisch eine sehr hohe Komplexität zu Stande. Eine gleichbleibende Logik für die Filter gibt es nicht, da diese mit Dashboards und Storys unterschiedlich agieren. Auch hierfür fehlt eine Anzeige, da der Anwender diese Logik aktiv oder unbewusst beeinflussen kann. Das Resultat des hohen Funktionsumfangs ist in diesem Testschritt ein hohes vorausgesetztes Wissen, eine gewöhnungsbedürftige Menüführung und dadurch unklare Arbeitsschritte. Lediglich der große Funktionsumfang ist positiv zu bewerten und insgesamt ergibt sich daher die Note 2,8.

Trend- und Referenzlinien sind ein einfach zu bedienendes Werkzeug und bieten viele Möglichkeiten. Jedoch benötigt man, um belastbare Ergebnisse zu erzielen, grundlegende statistische Kenntnisse. Da diese nicht grundsätzlich bei jedem Anwender vorhanden sind, wird in der Kategorie vorausgesetztes Wissen eine schlechtere Bewertung gegeben. Jedoch kann man auch ohne konkretes Fachwissen schnell eine Linie einfügen, formatieren und beschriften. Insgesamt ergibt sich eine Bewertung von 2,0.

Einen Schritt weiter als Trend- und Referenzlinien gehen Prognosen. Das Menü ist ähnlich leicht zu bedienen, jedoch ist für eine Kontrolle der Prognose etwas mehr Wissen gefragt, beispielsweise um das zu Grunde liegende Prognoseverfahren, zu verstehen. Für die Prognosen in Tableau kann der Nutzer leider nicht viele Parameter selbst einstellen und die Funktionalität ist in diesem Hinblick etwa eingeschränkt. Dies wirkt sich indessen für den durchschnittlichen Nutzer, ohne statistische Kenntnisse, positiv auf den Workflow aus. Es ergibt sich die Note 2,3.

Bei Berechnungen ist die Menüführung gut und es besteht die Möglichkeit über mehrere Stellen eine Berechnung zu erstellen. Das vorausgesetzte Wissen für einfache Berechnungen ist gering. Jedoch muss sich der Anwender die Syntax aneignen. Auch wenn Tableau Fehler anzeigt, sind diese nicht immer zu verstehen. Komplexere Berechnungen müssen, dank der eigenen Logik auf Dimensionsebene Tableaus, mit Hilfestellung der Trainingsvideos und Dokumente erlernt werden. Das vorausgesetzte Wissen ist trotzdem hoch und die Klarheit der Arbeitsschritte leidet unter ungenauen Fehlerhinweisen. Durch viele vordefinierte Rechenoperationen und Befehle bietet Tableau einen großen Funktionsumfang in diesem Testschritt. Berechnungen bieten daher an vielen Stellen einen deutlichen Mehrwert für den Anwender und können helfen, noch mehr Wissen aus den Daten zu extrahieren, vorausgesetzt, es sind die nötigen Kenntnisse vorhanden.

Ein weiteres positives Feature von Berechnungen, ist die Möglichkeit, das Statistik-Programm "R" einzubinden. Durch diese Schnittstelle kann direkt aus den Berechnungen R angesprochen werden und liefert die Ergebnisse direkt in Tableau. Damit lässt sich der Funktionsumfang deutlich erweitern und noch tiefer ins Detail gehende Analysen gestalten. Damit erzielt dieser Testschritt eine Note von 1,5.

Mit Karten lässt sich geographische Information eindrucksvoll darstellen. Tableau unterstützt den Anwender hierbei, in dem es zuverlässig diese Informationen aus dem Datensatz erkennt und das Feld in der Spalte der Dimensionen oder Kennzahlen hinzufügt. Daraus lässt sich mit wenigen, leichten Klicks eine Landkarte erstellen. Das Hinzufügen von Information funktioniert ähnlich wie bei anderen Visualisierungen und benötigt daher Übung. Möchte man Heatmaps oder interaktive Karten gestalten, erhöht sich der Schwierigkeitsgrad deutlich. Die Klarheit der Arbeitsschritte ist daher durchschnittlich zu bewerten. Karten bieten jedoch eine gute Möglichkeit, Informationen sehr anschaulich zu erforschen und präsentieren. Insgesamt erhält dieser Testschritt daher die Note 1.5.

Dashboards dienen am Ende einer Datenanalyse dazu, die gesammelten und aussagekräftigen Visualisierungen übersichtlich darzustellen. Das Erstellen gelingt sehr einfach über das gewohnte Drag&Drop. Ebenso einfach ist das Formatieren des Dashboards. Mit Storys bietet Tableau ein weiteres nützliches Feature an, um Dashboards interaktiver zu gestalten. Diese lassen sich ebenfalls relativ leicht erstellen. Der meiste Nutzen entsteht jedoch, wenn man Dashboards interaktiv gestaltet. Dadurch wird es dem Betrachter ermöglicht durch eigenes Klicken, Herumfahren mit dem Cursor und Einstellen von Filter- oder Parameteroptionen die Daten zu erfahren kann. Um dies zu machen, benötigt man das gesammelte, kombinierte Fachwissen und viel Übung aus den vorherigen Workflows. Es wird also sehr viel vorausgesetztes Wissen abverlangt. Jedoch ist positiv hervorzuheben, dass es schier endlose Möglichkeiten gibt, die Interaktivität einzubauen. Der Testschritt "Dashboards erstellen und bearbeiten" wird daher mit 1,8 bewertet.

7.2 SWOT-Analyse

Die Stärken, Schwächen, Chancen und Risiken von Tableau werden in Form von Abbildung 16 dargestellt, um daraus die möglichen Handlungsstrategien für Tableau zu erschließen und das Potenzial abzuleiten.

Die Stärken-Chancen-Strategie verknüpft die internen Stärken mit den externen Chancen, welche erst durch die Stärken genutzt werden können. Für Tableau bedeutet das, dass die Digitalisierung von Unternehmen und Gesellschaft dazu genutzt werden kann, viele Kunden an das Produkt heranzuführen, da vielen Anwendern ein leichter Einstieg gelingen kann. Mit dem breiten Schulungsangebot und der starken, aktiven Community bestehen gute Voraussetzungen, vom wachsenden Markt der Business Intelligence zu profitieren und weiterhin Kunden zu gewinnen. Data Analytics liegen auch 2020 weiter im Trend, wodurch es besonders wichtig ist, Kunden in die Produktentwicklung miteinzubinden. Diese Chance der Kundenbindung sollte Tableau weiterhin und langfristig nutzen und ausbauen. Durch die Community, in der viele Probleme, Wünsche und Anforderungen diskutiert werden, hat Tableau ein entsprechendes Medium dafür geschaffen.

Die Schwächen-Chancen-Strategie verbindet die internen Schwächen mit den externen Chancen, um aufzuzeigen, welche Chancen durch die Schwächen verpasst werden. Durch die hohen Anschaffungskosten, welche zunächst abschreckend wirken können, hebt Tableau teilweise die Stärke des leichten Einstiegs ins Programm auf. Zwar können viele neue Kunden durch den wachsenden Markt und starken Trend gewonnen werden, jedoch bieten Konkurrenten ähnliche, wenn auch teilweise geringere, Leistungen für einen deutlich geringeren Einstiegspreis an. Damit sind Kunden verloren, die primär auf den Preis achten. Des Weiteren besteht ein großes Problem durch die mangelnde Rechenleistung. Bei großen Datensätzen dauern Arbeitsschritte wie Datenimport, Vorbereitung und Analytics sehr lange, verglichen mit der Konkurrenz. Dies stellt nicht nur aktuell ein Problem dar, sondern wird noch sehr viel größer in Zukunft, da Big Data ein unaufhaltbarer Trend ist und daher die zu verarbeitenden Mengen wachsen.

Die Stärken-Schwächen-Strategie verbindet die Stärken mit den externen Risiken, um diese nach Möglichkeit zu verringern. Besonders große Risiken bestehen im stark umkämpften Markt durch Windows mit dem Produkt Power BI. Ein Produktumstieg ist für Windows-Nutzer nicht notwendig und bietet daher einen leichten Einstieg zu einem geringen Preis. Tableau kann dieses Risiko allerdings durch einen ebenfalls leichten Einstieg ins Produkt abfedern, sofern Kunden bereit sind, den hohen Einstiegspreis zu bezahlen. Durch die starke Kundeneinbindung hat sich Tableau einen Vorsprung gegenüber Konkurrenten erarbeitet. Dieser kann genutzt werden, um zu erkennen, welche Technologien und Innovationen wirklich von den Anwendern gewollt und gebraucht werden. So kann man schnell reagieren, sollten Kunden das Produkt wechseln wollen, da Konkurrenten bessere Innovationen hervorbringen. Andererseits kann sich Tableau Entwicklungskosten sparen, wenn Anwender von anderen Innovationen nicht profitieren und daher Funktionen erst gar nicht nutzen würden.

Die Schwächen-Risiken-Strategie kombiniert die internen Schwächen mit externen Risiken, um zu verdeutlichen, welchen Risiken man auf Grund der Schwächen ausgesetzt ist. Hier wird deutlich, dass die hohen Anschaffungskosten ein deutliches Risiko mit sich bringen. Denn die niedrigen Anschaffungskosten von Power BI im Vergleich zu Tableau sind ein starkes Argument, da sich der Preis direkt in der Erfolgsrechnung des Unternehmens wiederspiegelt. Anders, als der gewonnene Nutzen aus dem Produkt selbst. Somit könnte es für Tableau schwierig sein das enorme Wachstumspotenzial im wachsenden Markt vollständig zu nutzen. Eine weitere Gefahr entsteht durch die schwache Rechenleistung in Kombination mit Big Data der Anwender. Schon bei Datensätzen mit mehr als 30.000 Zeilen und einigen Spalten spürt der Anwender Verzögerungen. Qlik arbeitet hingegen für ähnliche Preise und viele Funktionen deutlich schneller, da eine andere Methode anwendet wird. So bleibt die Rechenleistung auch bei besonders großen Datensätzen, beispielsweise aus einer immer wieder aktualisierten, großen Datenbank, konstant hoch.

Abbildung 18: SWOT Übersicht

8. Diskussion

8.1 Implikationen für die Praxis

Der Einstieg in die Software von Tableau gelingt leicht und unkompliziert. Visualisierungen lassen sich schnell und einfach erstellen, sodass sich schnell Erfolgserlebnisse beim Anwender einstellen. Das kann einem Firmenmanagement helfen, die Akzeptanz bei Mitarbeitern zu steigern, wenn Tableau eingeführt wird. Allerdings gehen einfache Visualisierungen auch nicht über Diagrammfunktionalitäten von Excel hinaus. Jedoch wird durch den einfachen Einstieg die Motivation erhöht, an Schulungen aktiv teilzunehmen und somit mehr Nutzen aus dem Programm zu ziehen.